Realistische AI-video’s bedreiging voor democratie, waarschuwt UvA-onderzoeker

Steeds vaker duiken er online levensechte nepvideo’s op gemaakt door AI, die zich ook in Nederland lijken af te spelen. ‘In sommige gevallen is nep niet meer van echt te onderscheiden,’ zegt UvA-onderzoeker Laurens Naudts. Volgens hem ondermijnt die onzekerheid niet alleen het vertrouwen in deze video’s, maar ook in de democratie zelf.

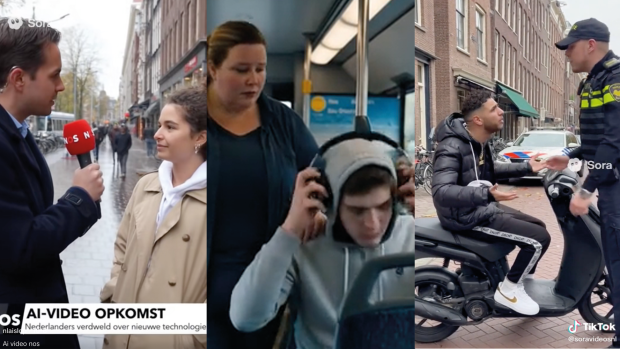

Een vrouw die belachelijk wordt maakt in een GVB-bus. Een politieagent die een boete geeft aan een gefrustreerde scooterrijder. En een NOS-verslaggever die iemand interviewt over ‘dat steeds meer filmpjes gemaakt worden met kunstmatige intelligentie’. Ironisch genoeg, terwijl ‘hij’ waarschuwt voor de opkomst van AI-video’s, is hij zelf het product van artificial intelligence (AI).

Maar deze NOS AI-verslaggever heeft wel gelijk; je kunt steeds meer door AI gegenereerde realistisch uitziende video’s online tegenkomen - ook die zich ogenschijnlijk afspelen in Nederland, onderstreept UvA-onderzoeker Laurens Naudts van het AI, Media & Democracy Lab en Instituut voor Informatierecht.

Meer en betere AI-video’s

Naudts onderzoekt onder andere hoe je de maatschappij kan beschermen tegen het steeds moeilijker wordende onderscheid tussen niet-artificiële en artificiële content. ‘Er is een opkomst van AI-modellen die zelf tekst, beeld of video genereren die breed beschikbaar zijn voor het publiek,’ zegt Naudts, ‘waardoor je meer AI-video’s tegenkomt op je sociale media tijdlijn. In sommige gevallen is nep niet meer van echt te onderscheiden.’

De meeste AI-beelden die je nu online tegenkomt zijn gemaakt met Sora 2.0, dat onderdeel is van het bedrijf OpenAI en dus dezelfde makers heeft als ChatGPT. Het is een AI-programma dat in een handomdraai een video kan genereren op basis van de opdracht die je schrijft. Met echte mensen: Sora kan het lichaam, stem en bewegingen nabootsen van echte mensen op basis van videodata waarmee het AI-model getraind is. Vorige maand kreeg Sora een grote update. Met de update van Sora kun je nu video’s van tien seconden maken met muziek, geluidseffecten en zelfs stemmen.

Er is alleen iets opvallends; als je in het Engels aan Sora 2.0 vraagt om Engelstalige media na te bootsen, weigert hij dat. Maar, schrijf je in het Nederlands, kan de videogenerator ineens wel beelden maken die nauwelijks te onderscheiden zijn van een echte NOS-verslaggever, meldt BNR. Waarom er een verschil afhankelijk van de taal van de aanvrager is, is niet duidelijk.

Risico’s

De opmars van hyperrealistische AI-video’s brengt volgens Naudts een reeks maatschappelijke risico’s met zich mee. ‘Het realisme van die beelden verhoogt de overtuigingskracht,’ zegt hij. ‘Dat maakt mensen kwetsbaarder voor misleiding, manipulatie en zelfs fraude.’

Een concreet risico is fraude door het nabootsen van bekende personen. ‘Je zou bijvoorbeeld iemands stem en uiterlijk kunnen repliceren om een deepfake te maken waarin die persoon om geld vraagt, ‘legt Naudts uit. ‘Stel je voor: je krijgt een videoboodschap van een familielid dat in nood lijkt te zijn en dringend geld nodig heeft. Door het realisme van de beelden kunnen mensen sneller geneigd zijn hierin te trappen.’ Daarnaast zou je met realistische deepfakes van iemand ze online kunnen pesten of seksueel intimideren, zegt Naudts.

Ook kan je met een paar klikken een video maken waarin een nieuwslezer, politicus of bekende Nederlander iets zegt wat hij of zij nooit werkelijk gezegd heeft om het publiek te misleiden of te manipuleren. ‘Je zou de stijl van het NOS Journaal en de presentator na kunnen bootsen om desinformatie te verspreiden, bijvoorbeeld over migratie en asiel, en daarmee de publieke opinie te beïnvloeden of verdeeldheid te zaaien,’ zegt Naudts. Zo circuleerden afgelopen week beelden over de zogenaamde arrestatie van toenmalig GroenLinks-PvdA lijststrekker Frans Timmermans omdat hij actiegroepen subsidieerde om te lobbyen in de EU voor zijn plannen. Deze beelden waren geplaatst op de politieke Facebookpagina ‘Wij doen GEEN aangifte tegen Geert Wilders.’

Hoewel hyperrealistische beelden het risico op misleiding kunnen vergroten, benadrukt Naudts dat ook minder overtuigende of zelfs overduidelijk neppe beelden al effect kunnen hebben, juist omdat ze emoties oproepen. ‘Zelf zag ik AI-beelden van de PVV in aanleiding naar de verkiezingen. Er waren AI-beelden gemaakt van een toekomstig Nederland als “kalifaat”,’ zegt Naudts. ‘Zo’n filmpje hoeft niet waarheidsgetrouw te zijn om een bepaald sentiment of politieke boodschap over te brengen.’ Volgens hem laat dat zien dat niet alleen hyperrealisme, maar ook de intentie en emotie achter de beelden bepaalt wat hun maatschappelijke impact is.

Wankelend vertrouwen

Dat AI-video’s steeds realistischer worden, heeft niet alleen gevolgen voor wat we zien, maar ook voor hoe we vertrouwen, zegt Naudts. ‘In een democratie gaan we ervan uit dat burgers informatie kunnen beoordelen en op basis daarvan een mening vormen. Daarvoor moet je wel kunnen inschatten waar die informatie vandaan komt en of het betrouwbaar is. Als dat onderscheid tussen echt en artificieel vervaagt, kan dat vertrouwen gaan wankelen.’

Volgens Naudts raakt dat wantrouwen niet alleen media of instituties, maar ook mensen zelf. Geïnspireerd op politiek filosoof Mark Coeckelbergh zegt Naudts: ‘Als je niet meer zeker weet of iets echt is, begin je te twijfelen aan je eigen oordeel. Dat kan er dan uiteindelijk weer toe leiden dat mensen zich minder uitspreken of minder deelnemen aan het publieke debat.’ Dit zou de basis van de democratie kunnen verzwakken omdat burgers minder geïnformeerd en betrokken raken.

Ook waarschuwt Naudts voor het gevaar dat iedereen bij voorbaat elke AI-video wantrouwt. ‘Niet elk gebruik van AI betekent dat iets onwaar is, en niet elke “echte” video vertelt de waarheid,’ zegt Naudts. Er moet voorkomen worden dat mensen in een reflex alles afwijzen wat met AI is gemaakt. ‘Het gaat erom dat mensen kunnen weten wat betrouwbaar is en blijven vertrouwen op kwaliteitsjournalistiek en instellingen die hun bronnen verifiëren.’

1. Zoek naar het watermerk. Zo zie je ‘Sora’ staan op videos gemaakt met Sora. Soms geven sociale media platforms zelf een ‘gemaakt door AI’ label.

2. Let op de details. In de virale video van konijnen op een trampoline versmelten twee tot één konijn in hun sprong. Ook zijn er foute schaduwen, rare weerspiegelingen en heeft AI moeite met het feit dat mensen vijf vingers hebben.

3. Kijk naar de tijdsaanduiding. Bij zogenaamd ‘beveiligingscamera’-beelden tikt de klok in AI-video’s vaak niet echt mee.

4. Luister goed. Stemmen klinken soms vlak of onnatuurlijk, met verkeerde klemtonen of mondbewegingen die niet kloppen.

Bescherming

Om jezelf te kunnen beschermen tegen realistische AI-video’s is het waarschuwen dat je een video kijkt gegeneerd door AI niet genoeg volgens Naudts. ‘Burgers moeten toegang hebben tot instrumenten en kennis om te begrijpen wat ze zien: waar een video vandaan komt, welke informatie het AI-model heeft gebruikt en met welke bedoeling AI is ingezet.’

Daarom pleit Naudts voor meer transparantie van de makers van AI-systemen én het in staat stellen van een sterkere journalistieke waakhondfunctie. ‘Mensen moeten kunnen vertrouwen op redacties en publieke instellingen die factchecken en inzicht geven in hoe iets is gemaakt,’ zegt hij. Om dat mogelijk te maken zou je volgens Naudts inzicht moeten kunnen krijgen in de herkomst van AI-beelden, bijvoorbeeld welke brondata of modellen zijn gebruikt bij de creatie ervan. Zulke openheid zou niet alleen burgers in staat stellen misleidende content te herkennen, maar ook journalisten helpen om hun controlerende rol beter te vervullen.

Op papier zijn er al stappen gezet om burgers te beschermen tegen misleidende AI-content. De Europese AI-verordening, die de komende tijd gefaseerd in werking treedt, moet ervoor zorgen dat het gebruik van kunstmatige intelligentie transparanter en veiliger wordt. Zo moeten bedrijven verplicht aangeven wanneer er AI is gebruikt voor een video, bijvoorbeeld via een zichtbaar watermerk.

Positieve inzet van AI-video’s

Realistische AI-video’s hoeven echter niet altijd een bedreiging te vormen. Naudts vertelt over journalisten in Venezuela, die vanwege repressie van het Maduro regime niet vrij hun werk kunnen doen. Zo werden journalisten om hun kritische vragen over de regering gevangen gehouden. Nu hebben de journalisten een oplossing gevonden met AI. ‘Daar wordt AI gebruikt om nieuws te brengen via digitale avatars, zodat verslaggevers anoniem kunnen blijven,’ zegt Naudts. ‘De avatars geven de warmte van een menselijke presentator, maar beschermen de echte makers tegen vervolging of geweld.’ Zulke toepassingen laten volgens Naudts zien dat AI ook kan bijdragen aan vrijheid van informatie, mits de inzet ervan transparant en verantwoord gebeurt.